- Auteur Lynn Donovan [email protected].

- Public 2023-12-15 23:51.

- Laatst gewijzigd 2025-01-22 17:35.

Uitzending variabelen in Apache Vonk is een mechanisme voor het delen van variabelen tussen uitvoerders die bedoeld zijn om alleen-lezen te zijn. Zonder uitzending variabelen deze variabelen zouden voor elke transformatie en actie naar elke uitvoerder worden verzonden, en dit kan netwerkoverhead veroorzaken.

Evenzo vragen mensen: wanneer moet ik Spark uitzenden?

Uitzending variabelen worden meestal gebruikt wanneer de taken in meerdere fasen dezelfde gegevens vereisen of wanneer de gegevens in de gedeserialiseerde vorm moeten worden opgeslagen. Uitzending variabelen worden gemaakt met behulp van een variabele v door SparkContext aan te roepen.

En wat zijn accumulatoren en uitzendvariabelen in Spark? Vonk ondersteunt twee soorten gedeelde variabelen : uitzendvariabelen , die kan worden gebruikt om een waarde in het geheugen op alle knooppunten te cachen, en accumulatoren , welke zijn variabelen die alleen worden “opgeteld”, zoals tellers en sommen.

Gezien dit, wat is een vonkaccumulator?

Accumulatoren zijn variabelen die alleen door een associatieve bewerking worden "toegevoegd" en daarom efficiënt parallel kunnen worden ondersteund. Ze kunnen worden gebruikt om tellers (zoals in MapReduce) of sommen te implementeren. Vonk native ondersteunt accumulatoren van numerieke typen, en programmeurs kunnen ondersteuning voor nieuwe typen toevoegen.

Hoe werk ik mijn uitzendvariabele in Spark bij?

- Verplaats het opzoeken van referentiegegevens naar een forEachPartition of forEachRdd, zodat het volledig op de werkers staat.

- Start de Spark-context elke keer dat de refdata verandert, opnieuw met een nieuwe Broadcast-variabele.

Aanbevolen:

Wat is MAP side join in spark?

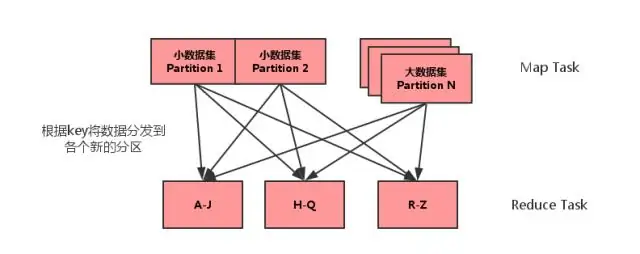

Map side join is een proces waarbij joins tussen twee tabellen worden uitgevoerd in de Map-fase zonder tussenkomst van de Reduce-fase. Met Map-side Joins kan een tabel in het geheugen worden geladen, wat zorgt voor een zeer snelle join-bewerking, volledig uitgevoerd in een mapper en dat ook zonder zowel kaart- als reductiefasen te hoeven gebruiken

Wat is er nieuw in Spark?

Afgezien van bugfixes, zijn er 2 nieuwe functies in Spark 2.4: SPARK-22239 Door de gebruiker gedefinieerde vensterfuncties met Panda's UDF. SPARK-22274 Door de gebruiker gedefinieerde aggregatiefuncties met panda's udf. We zijn van mening dat deze nieuwe functies de acceptatie van Pandas UDF verder zullen verbeteren, en we zullen Pandas UDF in volgende releases blijven verbeteren

Moet ik Hadoop voor Spark leren?

Nee, je hoeft Hadoop niet te leren om Spark te leren. Spark was een zelfstandig project. Maar na YARN en Hadoop 2.0 werd Spark populair omdat Spark samen met andere Hadoop-componenten bovenop HDFS kan draaien. Hadoop is een raamwerk waarin je MapReduce-taak schrijft door Java-klassen te erven

Wat is DataFrame in Spark Scala?

Een Spark DataFrame is een gedistribueerde verzameling gegevens die is georganiseerd in benoemde kolommen die bewerkingen biedt voor het filteren, groeperen of berekenen van aggregaten, en kan worden gebruikt met Spark SQL. DataFrames kunnen worden samengesteld uit gestructureerde gegevensbestanden, bestaande RDD's, tabellen in Hive of externe databases

Wat is beter om Spark of Hadoop te leren?

Nee, het is niet verplicht om eerst Hadoop te leren om Spark te leren, maar basiskennis van Hadoop en HDFS zal een voordeel zijn bij het leren van Spark. meer de voorkeur in de industrie