- Auteur Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:51.

- Laatst gewijzigd 2025-01-22 17:35.

Start de Vonk Beheers op meerdere knooppunten en zorg ervoor dat deze knooppunten hetzelfde hebben Dierentuinmedewerker configuratie voor Dierentuinmedewerker URL en map.

Informatie.

| Systeemeigenschap | Betekenis |

|---|---|

| vonk .aanwenden. dierentuinmedewerker .dir | De map in Dierentuinmedewerker om de herstelstatus op te slaan (standaard: / vonk ). Dit kan optioneel zijn |

Kun je daar vonk lokaal van maken?

Spark kan zijn loop met behulp van de ingebouwde standalone clusterplanner in de lokaal modus. Dit betekent dat alle Vonk processen zijn loop binnen dezelfde JVM-effectief, een enkele, multithreaded instantie van Vonk.

Ten tweede, kan Spark zonder Hadoop worden gebruikt? Vanaf Vonk documentatie, Spark kan loop zonder Hadoop . U kunt het uitvoeren als een zelfstandige modus zonder elke resourcemanager. Maar als je wilt draaien in multi-node setup, heb je een resource manager nodig zoals YARN of Mesos en een gedistribueerd bestandssysteem zoals HDFS , S3 enz. Ja, vonk kan loop zonder hadoop.

Ook om te weten is waarom ZooKeeper wordt gebruikt in Hadoop?

Dierentuinmedewerker in Hadoop kan worden gezien als een gecentraliseerde opslagplaats waar gedistribueerde applicaties gegevens kunnen plaatsen en er gegevens uit kunnen halen. Het is gebruikt om het gedistribueerde systeem samen te laten functioneren als een enkele eenheid, met behulp van de synchronisatie-, serialisatie- en coördinatiedoelen.

Hoe werkt Spark standalone?

Standalone mode is een eenvoudige clustermanager die is geïntegreerd met: Vonk . Het maakt het gemakkelijk om een cluster op te zetten dat: Vonk zelf beheert en kan draaien op Linux, Windows of Mac OSX. Vaak is het de eenvoudigste manier om te rennen Vonk toepassing in een geclusterde omgeving. Leren, hoe te installeren Apache Spark Op Standalone Modus.

Aanbevolen:

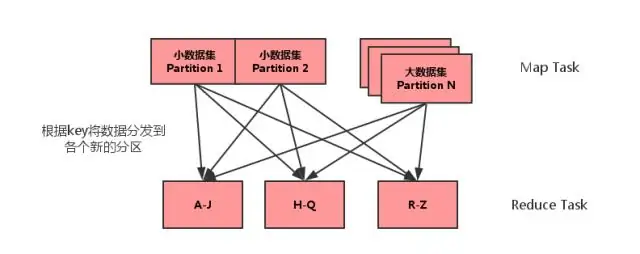

Wat is MAP side join in spark?

Map side join is een proces waarbij joins tussen twee tabellen worden uitgevoerd in de Map-fase zonder tussenkomst van de Reduce-fase. Met Map-side Joins kan een tabel in het geheugen worden geladen, wat zorgt voor een zeer snelle join-bewerking, volledig uitgevoerd in een mapper en dat ook zonder zowel kaart- als reductiefasen te hoeven gebruiken

Wat is er nieuw in Spark?

Afgezien van bugfixes, zijn er 2 nieuwe functies in Spark 2.4: SPARK-22239 Door de gebruiker gedefinieerde vensterfuncties met Panda's UDF. SPARK-22274 Door de gebruiker gedefinieerde aggregatiefuncties met panda's udf. We zijn van mening dat deze nieuwe functies de acceptatie van Pandas UDF verder zullen verbeteren, en we zullen Pandas UDF in volgende releases blijven verbeteren

Moet ik Hadoop voor Spark leren?

Nee, je hoeft Hadoop niet te leren om Spark te leren. Spark was een zelfstandig project. Maar na YARN en Hadoop 2.0 werd Spark populair omdat Spark samen met andere Hadoop-componenten bovenop HDFS kan draaien. Hadoop is een raamwerk waarin je MapReduce-taak schrijft door Java-klassen te erven

Welke versie van Python gebruikt Spark?

Spark draait op Java 8+, Python 2.7+/3.4+ en R 3.1+. Voor de Scala-API, Spark 2.3. 0 gebruikt Scala 2.11. U moet een compatibele Scala-versie gebruiken (2.11

Hoe stel ik Spark Instant Messenger in?

Spark IM-installatiehandleiding Download Spark van de Spark IM-website. Installeer en start Spark op uw computer. Voer uw Olark-gebruikersnaam in het bovenste veld in, uw wachtwoord in het middelste veld en "@olark.com" voor het domein. Druk op enter en je bent ingelogd op Spark IM! Veel plezier met chatten