- Auteur Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:51.

- Laatst gewijzigd 2025-01-22 17:35.

In termen van de leek, de zelf - aandacht mechanisme zorgt ervoor dat de inputs met elkaar kunnen interageren (“ zelf ”) en ontdek wie ze meer moeten betalen aandacht tot ( aandacht ”). de uitgangen zijn aggregaten van deze interacties en aandacht scoort.

En wat is zelfaandacht?

Zelf - aandacht , soms intra- aandacht is een aandacht mechanisme dat verschillende posities van een enkele reeks met elkaar in verband brengt om een representatie van de reeks te berekenen.

En wat is zelfaandacht bij deep learning? Laten we eerst definiëren wat “ zelf - Aandacht " is. Cheng et al, in hun artikel genaamd "Long Short-Term Memory-Networks for" Machine Lezen”, gedefinieerd zelf - Aandacht als het mechanisme om verschillende posities van een enkele reeks of zin met elkaar in verband te brengen om een meer levendige weergave te krijgen.

Wat is hierover het aandachtsmechanisme?

Aandachtsmechanisme: stelt de decoder in staat om bij elke stap van het genereren van uitvoer verschillende delen van de bronzin te behandelen. In plaats van de invoerreeks te coderen in een enkele vaste contextvector, laten we het model leren hoe een contextvector kan worden gegenereerd voor elke uitvoertijdstap.

Wat is een op aandacht gebaseerd model?

Aandacht - gebaseerde modellen behoren tot een klasse van modellen gewoonlijk sequentie-naar-sequentie genoemd modellen . Het doel van deze modellen , zoals de naam al doet vermoeden, het om een uitvoerreeks te produceren gegeven een invoerreeks die in het algemeen verschillende lengtes heeft.

Aanbevolen:

Hoe werkt Spring AOP-proxy?

AOP-proxy: een object gecreëerd door het AOP-raamwerk om de aspectcontracten te implementeren (adviseren methode-uitvoeringen enzovoort). In het Spring Framework zal een AOP-proxy een dynamische JDK-proxy of een CGLIB-proxy zijn. Weven: aspecten koppelen aan andere applicatietypes of objecten om een geadviseerd object te maken

Hoe werkt een spiegel-tv?

Een spiegel-tv bestaat uit speciaal semi-transparant spiegelglas met achter het spiegeloppervlak een lcd-tv. De spiegel is zorgvuldig gepolariseerd zodat een beeld door de spiegel kan worden overgebracht, zodat wanneer de tv uit staat, het apparaat eruitziet als een spiegel

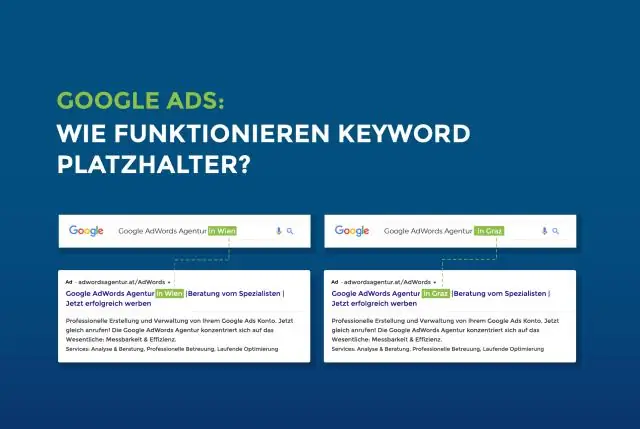

Hoe werkt placeholder?

Het placeholder-attribuut specificeert een korte hint die de verwachte waarde van een invoerveld beschrijft (bijvoorbeeld een voorbeeldwaarde of een korte beschrijving van het verwachte formaat). Opmerking: het kenmerk placeholder werkt met de volgende invoertypen: tekst, zoeken, url, tel, e-mail en wachtwoord

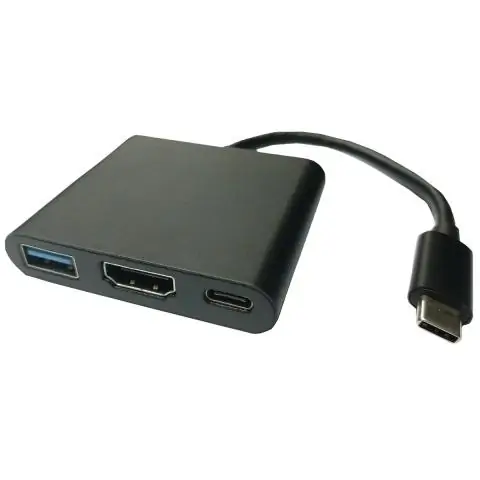

Hoe werkt een USB-beeldschermadapter?

USB-videoadapters zijn apparaten die één USB-poort nemen en naar één of meerdere video-aansluitingen gaan, zoals VGA, DVI, HDMI of DisplayPort. Dit is handig als u een extra beeldscherm aan uw computerconfiguratie wilt toevoegen, maar geen videoverbindingen op uw computer hebt

Hoe werkt foutcorrectiecode?

Een foutcorrigerende code is een algoritme om een reeks getallen zodanig uit te drukken dat eventuele fouten die worden geïntroduceerd, kunnen worden gedetecteerd en gecorrigeerd (binnen bepaalde beperkingen) op basis van de resterende getallen. De studie van foutcorrigerende codes en de bijbehorende wiskunde staat bekend als coderingstheorie