- Auteur Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:51.

- Laatst gewijzigd 2025-01-22 17:35.

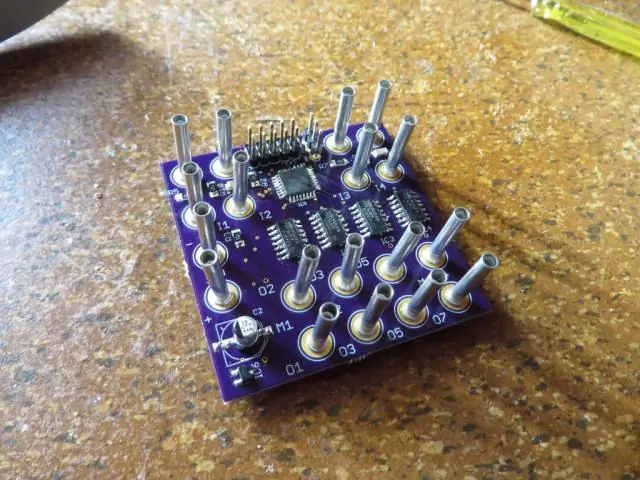

1) Klein bestand probleem in HDFS : Veel opslaan kleine bestanden die extreem zijn kleiner dan kan de blokgrootte niet efficiënt worden afgehandeld door HDFS . Doorlezen kleine bestanden veel zoeken en veel hoppen tussen gegevensknooppunt naar gegevensknooppunt, wat op zijn beurt inefficiënte gegevensverwerking is.

Daarnaast, welke bestanden behandelen problemen met kleine bestanden in Hadoop?

1) HAR ( Hadoop Archief) Bestanden heeft kennis gemaakt met omgaan met kleine bestandsproblemen . HAR heeft er een laag bovenop gentroduceerd HDFS , die een interface bieden voor het dossier toegang krijgen. Gebruik makend van Hadoop archiefopdracht, HAR bestanden worden gemaakt, die loopt KaartVerminderen taak om de bestanden gearchiveerd worden in kleiner aantal HDFS-bestanden.

Kan ik bovendien meerdere bestanden in HDFS verschillende blokgroottes laten gebruiken? Standaard maat van blok is 64 MB. jij kan verander het afhankelijk van uw behoefte. Komend op je vraag ja jij kan meerdere bestanden maken door te variëren blok maten maar in realtime dit zullen niet gunstig voor de productie.

Bovendien, waarom kan HDFS kleine bestanden niet optimaal verwerken?

Problemen met kleine bestanden en HDFS Elk het dossier , directory en blok in HDFS is weergegeven als een object in het geheugen van de namenode, die elk 150 bytes in beslag nemen, als vuistregel. Verder, HDFS is niet gericht op efficiënt toegang kleine bestanden : het is voornamelijk ontworpen voor streamingtoegang van grote bestanden.

Waarom is Hadoop traag?

Traag Verwerkingssnelheid Deze schijf zoeken kost tijd, waardoor het hele proces erg traag . Indien Hadoop gegevens in een klein volume verwerkt, is het erg traag relatief. Het is ideaal voor grote datasets. Als Hadoop heeft een batchverwerkingsengine als kern, de snelheid voor realtime verwerking is minder.

Aanbevolen:

Wat zijn de pictogrammen met een kleine pijl in de linkerbenedenhoek?

De kleine pijl in de linkerbenedenhoek van een pictogram geeft aan dat het pictogram een snelkoppelingspictogram is. Snelkoppelingspictogrammen zijn voor het starten van het programma dat het vertegenwoordigt

Hoe meld ik een probleem met de vaste lijn van AT&T?

Hoe controleer ik de status van een storingsmelding? Bel 1 800-288-2747. Volg de aanwijzingen om uw gegevens te verifiëren totdat u 'Dit is het hoofdmenu' hoort. Zodra u het hoofdmenu hebt bereikt, drukt u op 3 voor 'Problemen zonder kiestoon of andere lokale reparatie- en onderhoudsproblemen'

Wat is het proces van het definiëren van twee of meer methoden binnen dezelfde klasse met dezelfde naam maar met verschillende parameters?

Overbelasting van de methode De handtekening van een methode bestaat niet uit het retourtype, de zichtbaarheid of de uitzonderingen die het kan veroorzaken. De praktijk van het definiëren van twee of meer methoden binnen dezelfde klasse die dezelfde naam hebben maar verschillende parameters hebben, wordt overbelastingsmethoden genoemd

Hoe repareer je een computer met een probleem?

Als uw pc een probleem heeft ondervonden en het bericht opnieuw moet worden opgestart, kunt u het probleem als volgt oplossen: Druk op Windows-toets + S en voer het geavanceerde systeem in. Klik op het tabblad Geavanceerd bovenaan in het venster Eigenschappen. Klik onder het onderwerp Opstarten en herstellen met de linkermuisknop op Instellingen

Hoe los ik het probleem met gemengde inhoud van WordPress op?

Volg deze KB voor het maken van een back-up van de server en de applicatie. Stap 1: Log in op uw WordPress-beheerderspaneel. Browse naar het beheerdersdashboard van uw WordPress-website en voer uw beheerdersgegevens in om u aan te melden. Stap 2: Los het probleem met gemengde inhoud op Installeer de echt eenvoudige SSL-plug-in. Stap 3: Controleer of het probleem is opgelost